Отладка программы

Отладка программы — процесс выявления основной причины, поиска обходных решений и устранения ошибок в инженерных системах, в том числе в программном обеспечении[1]. В программной инженерии для отладки используются такие методы, как интерактивная отладка, анализ управления потоком выполнения, анализ логов, мониторинг на уровне приложения или системы, дампы памяти и профилирование. Многие языки программирования и инструменты разработки включают специализированные программы, называемые отладчиками.

Этимология

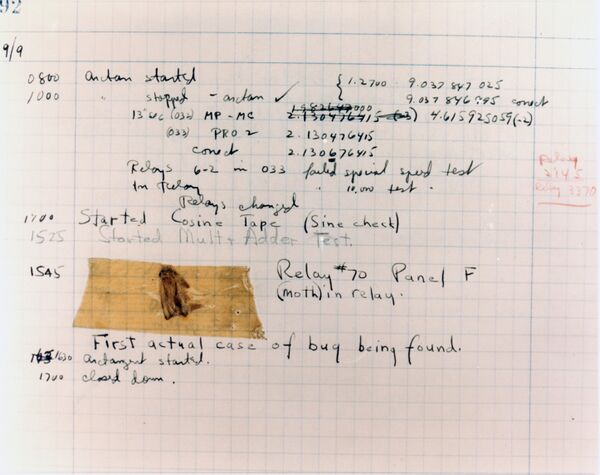

Термин «ошибка» в значении «дефект» известен по крайней мере с 1878 года, когда Томас Эдисон упоминал в письме «маленькие дефекты и трудности» в своих изобретениях как «Bugs».

Одна из известных историй 1940-х годов связана с адмиралом Грейс Хоппер. Когда она работала с компьютером Mark II в Гарвардском университете, её коллеги обнаружили моль, застрявшую в реле и нарушавшую работу устройства. В журнале была сделана запись: «First actual case of a bug being found» («Первый реальный случай обнаружения ошибки»). Хотя это игра слов, совмещающая биологическое значение слова и инженерное, этот случай иллюстрирует, что термин уже применялся в компьютерной области.

Термин «отладка» использовался в авиации ещё до появления компьютеров. В письме Роберта Оппенгеймера, директора Манхэттенского проекта, к Эрнесту Лоуренсу из Калифорнийского университета в Беркли от 27 октября 1944 года[2], термин был использован применительно к набору техники. В «Oxford English Dictionary» словарная статья для «debug» ссылается на статью 1945 года в "Journal of the Royal Aeronautical Society" о тестировании авиационных двигателей. Статья в журнале "Airforce" (июнь 1945, с. 50) также упоминает отладку авиационных камер.

Знаковая статья Гилла[3] 1951 года была первой глубокой работой об ошибках программирования, хотя термины «bug» и «debugging» там не использовались.

В цифровой библиотеке ACM термин «debugging» впервые встречается в трёх статьях материалов национальных конференций ACM 1952 года. Два из этих трёх упоминаний даны в кавычках.

К 1963 году «отладка» настолько вошла в обиход, что в руководстве по Compatible Time-Sharing System термин упоминался без пояснений с первой страницы.

История

В 1970-е годы произошёл концептуальный сдвиг в подходах к отладке, связанный с ростом сложности программного обеспечения. Ключевым изменением стал переход к структурному программированию, популяризированному работами Эдсгера Дейкстры. Эта парадигма предлагала отказаться от беспорядочного использования операторов перехода (GOTO) в пользу трёх базовых управляющих конструкций: последовательности, ветвления (if-then-else) и цикла[4]. Целью было повышение читаемости кода, что, в свою очередь, сокращало количество ошибок и облегчало их поиск[5]. В рамках этого подхода сложные задачи разбивались на более мелкие, управляемые модули с чётко определёнными интерфейсами, что позволяло отлаживать их независимо друг от друга[5]. Процесс разработки стал более формализованным с появлением в 1970 году каскадной модели, которая вводила строгую последовательность этапов, включая проектирование, кодирование и отладку[6].

Несмотря на новые методологии, широко применялись и ручные методы. Одним из самых распространённых оставалась отладка с помощью печати (англ. print debugging), когда программисты вставляли в код операторы вывода для отслеживания значений переменных и последовательности выполнения[7]. При работе с мейнфреймами в режиме пакетной обработки программисты анализировали бумажные распечатки, содержащие код, сообщения об ошибках и шестнадцатеричные дампы памяти[7]. Распространённой практикой была и «настольная» отладка — пошаговый анализ распечатанного кода на бумаге[8].

В то же время развивались и более совершенные инструменты. На мини-ЭВМ и мейнфреймах с терминальным доступом стали распространяться интерактивные отладчики. Появились полноэкранные отладчики, такие как OLIVER для IBM 360/370, которые позволяли устанавливать точки останова и пошагово выполнять код. На мини- и микрокомпьютерах программисты также использовали переключатели и светодиодные индикаторы на передней панели для изучения и изменения содержимого ячеек памяти и регистров процессора[7].

Вершиной технологий отладки того времени стали внутрисхемные эмуляторы (англ. In-Circuit Emulator, ICE). Первый коммерческий ICE был выпущен компанией Intel в 1975 году для своего процессора 8080[7]. Это было аппаратное устройство, которое подключалось к целевой плате вместо процессора, позволяя в реальном времени контролировать и отслеживать выполнение кода на реальном оборудовании. ICE стали незаменимы для отладки встраиваемых систем, где отсутствовали экраны и клавиатуры[7].

1980-е годы стали революционным периодом для отладки программного обеспечения, что было обусловлено рассветом эры персональных компьютеров. Десятилетие ознаменовалось переходом от ручных методов анализа к мощным интерактивным инструментам, заложившим основу для современных интегрированных сред разработки (IDE). В начале десятилетия многие программисты всё ещё полагались на методы, унаследованные от эпохи мейнфреймов, такие как отладочная печать (англ. printf debugging) и ручная трассировка кода на бумаге. Инструменты вроде `DEBUG` в MS-DOS позволяли работать с программой на уровне машинных кодов, что было крайне неинтуитивно[9].

Ключевым прорывом середины 1980-х стало появление символьных отладчиков, которые могли сопоставлять исполняемый код с исходным текстом программы, позволяя разработчикам работать в терминах переменных и функций, а не адресов памяти. Среди знаковых инструментов этого периода выделяются:

- Microsoft CodeView (1985) — выпущенный вместе с Microsoft C 4.0, CodeView стал одним из первых широко распространённых полноэкранных отладчиков для MS-DOS[9]. Он предлагал многооконный интерфейс для одновременного просмотра исходного кода, значений переменных, памяти и регистров, а также поддерживал пошаговое выполнение на уровне строк исходного кода[9][10].

- SoftICE (1987) — низкоуровневый отладчик от компании NuMega, написанный на ассемблере для процессора 80386[11]. Его уникальность заключалась в том, что он работал на уровне операционной системы, используя возможности виртуального режима процессора[11]. Это позволяло отлаживать «зависшие» программы, «всплывая» поверх любого приложения, и не требовало второго компьютера для сеанса отладки[11].

- Borland Turbo Debugger (1989) — мощный отладчик, поставлявшийся с Turbo C и Turbo Assembler[12]. Он был частью экосистемы Borland, которая формировала одну из первых полноценных IDE, позволяя писать, компилировать и отлаживать код, не переключаясь между разными программами[13][9].

Появление таких продуктов, как Turbo Pascal (с 1983 года), ознаменовало зарождение концепции IDE[14]. Turbo Pascal стал одним из первых коммерчески успешных продуктов, объединивших в одной программе текстовый редактор, быстрый компилятор и отладчик[15][16]. Возможность редактировать, компилировать и отлаживать программу в едином окне значительно ускорила цикл разработки и стала стандартом для последующих десятилетий.

1990-е годы стали периодом массового перехода к интегрированным средам разработки (IDE), которые объединяли в одном приложении текстовый редактор, компилятор и отладчик. Эта тенденция была во многом обусловлена ростом популярности операционных систем с графическим интерфейсом, в первую очередь Microsoft Windows[17].

Ключевым событием стал выпуск Visual Basic в 1991 году, который предложил революционную для своего времени концепцию визуальной разработки интерфейсов (англ. Rapid Application Development, RAD)[18]. Microsoft закрепила успех, выпустив Visual C++ с мощным встроенным отладчиком[19], а кульминацией стало создание в 1997 году Visual Studio 97, объединившей инструменты для нескольких языков и на долгие годы ставшей отраслевым стандартом[17]. В то же время компания Borland оставалась сильным конкурентом, выпуская для Windows среду Delphi — наследника Turbo Pascal[17].

Параллельно с IDE продолжали развиваться и узкоспециализированные инструменты для сложных задач. Легендарным отладчиком уровня ядра для DOS и Windows был SoftICE от компании NuMega. Его уникальность заключалась в способности работать «под» операционной системой, что позволяло приостанавливать работу всей системы для анализа состояния, отладки драйверов и даже ядра ОС[20][21]. В мире Unix-подобных систем основным инструментом был GDB, развивавшийся в рамках проекта GNU. Будучи отладчиком с интерфейсом командной строки, он предоставлял широкие возможности для трассировки программ и стал незаменимым для разработки встраиваемых систем благодаря поддержке удалённой отладки[22].

Несмотря на появление продвинутых инструментов, старые методы не утратили своей актуальности. Отладка с помощью печати (англ. printf debugging) оставалась распространённой практикой из-за своей универсальности[23]. Для низкоуровневых задач в среде MS-DOS по-прежнему использовалась команда `DEBUG`[24], а при анализе сложных алгоритмов программисты прибегали к «бумажной» отладке — пошаговому выполнению кода на бумаге[19].

2000-е годы стали периодом зрелости для интегрированных сред разработки (IDE), которые из популярных инструментов превратились в основной рабочий стандарт для большинства программистов[25]. Среды этого периода, такие как Visual Studio .NET, Eclipse и NetBeans, предлагали тесную интеграцию редактора кода, компилятора и отладчика в едином графическом интерфейсе[26]. Это позволило выполнять пошаговую отладку, устанавливать точки останова, просматривать значения переменных и стек вызовов, не переключаясь между разными программами[25].

Начало десятилетия ознаменовалось появлением платформ, изначально созданных с мощной поддержкой отладки. Платформа Java, благодаря своей виртуальной машине (JVM), предоставляла широкие возможности для анализа кода, а выпущенная в 2001 году IDE Eclipse стала для неё отраслевым стандартом. В 2000 году Microsoft представила язык C# и платформу .NET Framework вместе со средой Visual Studio .NET, которая установила новый стандарт для визуальной отладки сложных приложений, включая веб-сервисы и десктопные программы[27]. В этот же период появился язык D, который также получил поддержку со стороны отладчиков, в частности GDB.

С ростом популярности интернета усложнилась и веб-разработка. Для отладки серверных скриптов на языках вроде PHP, Perl и Python потребовались специализированные инструменты. В этот период набрали популярность такие проекты, как Xdebug для PHP, позволявшие удалённо подключаться к серверному коду и использовать точки останова, как в классических десктопных приложениях. Одновременно начали появляться первые встроенные в браузеры инструменты для отладки JavaScript, заложившие основу для современных «Инструментов разработчика» (англ. Developer Tools).

Несмотря на доминирование IDE, продолжали активно развиваться и низкоуровневые отладчики, такие как GDB в мире Linux и WinDbg в Windows[28]. Они оставались незаменимыми для системного программирования, разработки драйверов, анализа дампов памяти после сбоев и решения сложных проблем, особенно при работе с кодом без исходников[28]. В 2000-е эти инструменты были адаптированы для поддержки набиравших распространение 64-разрядных архитектур.

Рост производительности процессоров привёл к широкому распространению многопоточного и параллельного программирования. Это создало новые вызовы для отладки, так как традиционные методы с точками останова могли изменять поведение программы и скрывать ошибки, связанные с синхронизацией потоков (так называемые гейзенбаги). Это стимулировало исследования в области неинтрузивных методов отладки и анализа параллельных приложений.

Десятилетие 2010-х годов стало переломным для индустрии программного обеспечения, что коренным образом изменило подходы к отладке. Переход от монолитных приложений к распределённым системам, рост облачных вычислений и утверждение культуры DevOps потребовали новых инструментов и методологий[29].

Ключевой тенденцией стало внедрение практик непрерывной интеграции и доставки (CI/CD), в рамках которых отладка перестала быть изолированным этапом[30]. Акцент сместился на «сдвиг влево» (англ. shift left) — максимально раннее обнаружение ошибок через автоматизированные тесты, что сделало отладку непрерывным процессом[29]. Главным вызовом стала отладка микросервисных архитектур, где запрос проходит через множество независимых сервисов. В ответ на это получила развитие концепция наблюдаемости (англ. observability), основанная на трёх компонентах: централизованном сборе логов, сборе метрик о состоянии системы и распределённой трассировке для отслеживания пути запроса через все компоненты[29].

Одной из самых значимых технологических инноваций десятилетия стала отладка с возможностью «путешествия во времени» (англ. Time-Travel Debugging, TTD), также известная как реверсивная отладка[31]. Эта технология позволяет записывать выполнение программы и затем воспроизводить его, двигаясь не только вперёд, но и назад по временной шкале, что неоценимо при поиске трудновоспроизводимых ошибок (гейзенбагов)[32]. Ключевые события в развитии TTD в этот период:

- В GDB поддержка реверсивной отладки была добавлена в версии 7.0, выпущенной 6 октября 2009 года[33].

- Microsoft сделала общедоступным свой инструмент TTD, интегрировав его в WinDbg Preview 27 сентября 2017 года[34][35].

- Появились и другие инструменты, реализующие схожий функционал, такие как `rr` и `Undo`[31].

Традиционные отладчики также продолжали развиваться. В 2010 году был представлен LLDB — новый отладчик, созданный в рамках проекта LLVM как модульная и высокопроизводительная альтернатива GDB, тесно интегрированная с компилятором Clang[36]. Миграция инфраструктуры в облако стимулировала развитие инструментов для удалённой отладки и усилила потребность в централизованном сборе логов и метрик, что тесно связано с концепцией наблюдаемости[37].

Развитие отладки в 2020-е годы характеризуется тремя ключевыми тенденциями: массовой интеграцией искусственного интеллекта (ИИ) в среды разработки, зрелостью технологий «путешествия во времени» (англ. Time-Travel Debugging, TTD) и широким внедрением практик наблюдаемости (англ. Observability) для сложных распределённых систем[38].

Значительным прорывом стало внедрение ИИ-ассистентов, которые из вспомогательных инструментов превратились в «вторых пилотов» для разработчиков[39]. Флагманским инструментом эпохи стал GitHub Copilot, представленный в 2021 году и ставший общедоступным в 2022-м[40]. Он способен объяснять ошибки, предлагать исправления и отвечать на вопросы по коду прямо в редакторе[41]. Вслед за ним появились и другие ИИ-ассистенты, такие как JetBrains AI Assistant, Amazon Q Developer и Sourcegraph Cody, а также специализированные инструменты вроде CodiumAI для автоматической генерации тестов[41].

Технология Time-Travel Debugging (TTD), или реверсивная отладка, в этот период достигла зрелоosti и стала доступной широкому кругу разработчиков. Она позволяет записывать выполнение программы и затем перемещаться по нему как вперёд, так и назад во времени, что особенно эффективно для отладки трудновоспроизводимых ошибок (гейзенбагов). Ключевыми инструментами стали WinDbg Preview с улучшенной поддержкой TTD, включая архитектуру ARM64[42], инструмент `rr` для Linux и веб-ориентированный отладчик Replay.io, запущенный в 2021 году для JavaScript, который позволяет записывать и делиться сессиями отладки[43].

С ростом популярности микросервисной архитектуры и облачных вычислений традиционного мониторинга стало недостаточно. На смену ему пришла концепция наблюдаемости, которая позволяет судить о внутреннем состоянии системы по её внешним данным: метрикам, логам и трассировкам, отвечая на вопрос «почему система не работает?»[44]. Ключевым стандартом в этой области стал проект OpenTelemetry (OTel), который предоставляет единый набор API и SDK для сбора телеметрических данных и компоненты которого достигли общей доступности в 2020-х годах[45]. Для отладки в средах вроде Kubernetes получили развитие инструменты, подобные Telepresence, позволяющие «проксировать» трафик из удалённого кластера на локальную машину разработчика для использования локальных отладчиков[46].

Область применения

С усложнением программного обеспечения и электронных систем отладочные методы становятся всё разнообразнее, чтобы выявлять аномалии, оценивать их последствия и планировать исправления или обновления. Для нейтральности часто используют термины «аномалия» и «несоответствие» вместо «ошибка» и «дефект», чтобы избежать предположения, что любую такую ситуацию обязательно нужно устранять. Вместо этого проводят оценку воздействия, чтобы понять, стоит ли вносить изменения. Иногда очередное плановое обновление системы позволит не вносить частичные исправления вовсе. Не все проблемы являются критичными с точки зрения безопасности или работоспособности. Кроме того, некоторые изменения могут быть менее удобными для пользователя, чем сама известная проблема («лечение хуже болезни»). Принятие решений об уровне допустимых аномалий позволяет избежать жёсткого подхода «никаких дефектов» — когда наличие проблем скрывается ради видимости идеального состояния. Оценка соотношения затрат и выгод помогает расширить отладочные методы за счёт количественного анализа частоты аномалий для оценки их значимости для всей системы.

Инструменты

Отладка может быть как тривиальной (например, исправление опечатки), так и требующей длительного сбора и анализа данных или подготовки обновлений. Навыки программиста существенно влияют на успешное устранение ошибок, однако сложность отладки зависит от устройства самой системы, а также от используемого языка программирования и наличия специализированных инструментов — отладчиков. Отладчик — это программа, позволяющая программисту контролировать выполнение программы, останавливать, перезапускать её, устанавливать точки останова, изменять значения в памяти. Иногда под «отладчиком» понимается и сам человек, занимающийся отладкой.

Высокоуровневые языки программирования, такие как Java, обычно более удобны для отладки благодаря поддержке таких средств, как обработка исключений и проверка типов; с их помощью быстрее определяется источник нестабильного поведения. В языках типа C или ассемблера ошибки могут приводить к незаметным сбоям вроде повреждения памяти, и выяснить первопричину бывает сложно; тогда используют специальные инструменты, называемые отладчиками памяти.

В ряде случаев полезны независимые от языка инструменты статического анализа кода — они ищут известные ошибки по исходному коду, концентрируясь на семантических особенностях (например, движение данных), а не только на синтаксисе, как компиляторы. Коммерческие и бесплатные инструменты существуют для многих языков программирования и могут выявлять сотни различных типов ошибок — например, разыменование переменной до присвоения значения. Некоторые средства выполняют и строгую проверку типов для нетипизированных языков. При этом возможны ложноположительные срабатывания (код работает, но помечается подозрительным). Ранним примером таких средств служит утилита lint в UNIX.

Для отладки электронной аппаратуры, а также низкоуровневого программного обеспечения (BIOS, драйверов устройств, прошивок) широко используются осциллографы, логические анализаторы и внутрисхемные эмуляторы (ICE). ICE часто совмещают функции программного отладчика для низкоуровневого ПО и микропрограмм.

Процесс отладки

Процесс отладки представляет собой итеративный цикл, который обычно включает несколько ключевых этапов[47]:

- Обнаружение ошибки. Ошибка может быть выявлена в процессе тестирования, на основе отчётов от пользователей или обнаружена самим разработчиком во время работы[47].

- Воспроизведение ошибки. Создание условий, при которых ошибка стабильно повторяется, для её изучения[47]. Это не всегда просто, особенно в параллельных или сильно зависящих от окружения случаях (га́йзенбаги). Особенности среды пользователя и история её использования могут сделать повторение ошибки затруднительным.

- Локализация проблемы. Определение точного места в коде, которое вызывает ошибку[47]. Для этого может потребоваться упростить входные данные программы — так её поведение легче отследить. Например, ошибка компилятора может проявляться только при разборе большого файла, но, сокращая тестовый пример, можно оставить от исходного кода лишь несколько строк, необходимых для воспроизведения сбоя. Такой подход часто реализуется вручную по принципу «разделяй и властвуй», когда части тестового случая поочерёдно удаляются и проверяется, сохраняется ли проблема. При отладке графических интерфейсов пользователь может последовательность действий частично исключить для проверки, сохраняется ли ошибка.

- Анализ и исправление. После достаточного упрощения теста программист использует отладчик для анализа состояния программы (значения переменных, стек вызовов) и поиска причины проблемы. Альтернативно применяется трассировка — вывод текущих значений переменных в заданные моменты работы программы. Поняв причину, разработчик вносит изменения в код для её устранения[47].

- Проверка исправления. Повторное тестирование, чтобы убедиться, что ошибка исправлена и при этом не были созданы новые ошибки (регрессии)[48].

Приёмы

- Интерактивная отладка — использование отладчика, позволяющего поэтапно выполнять программу, останавливать её и анализировать/менять состояние. Часто можно выполнять подпрограммы целиком, устанавливать точки останова, после которых выполнение прерывается, а также задавать наблюдаемые переменные (watchpoints), чтобы остановиться при их изменении, или особые события (catchpoints), например при возникновении исключения.

- Печать значений (print debugging) или трассировка — наблюдение за выводом диагностических или отладочных сообщений, обычно специальных операторов вывода, в которых фиксируется ход выполнения и изменение данных. В языке C часто используется функция printf (отсюда выражение "printf-отладка"); в BASIC для этой цели служила команда TRON («Trace ON»), печатавшая номера строк при выполнении программы.

- Трассировка активности — сбор сводной статистики по процессору/CPU по тому, сколько времени программа тратит на отдельные участки кода; результаты отображают долю времени, занятую теми или иными процедурами или модулями. Если значительная доля времени тратится на ожидаемо несложные операции, это признак неэффективности или ошибки в логике.

- Удалённая отладка — процесс отладки программ, работающих на другой машине; отладчик соединяется с удалённой системой по сети и управляет программой, получая состояние.

- Посмертная отладка — анализ программ после аварийного завершения (краха). Используются логи, стек вызовов при сбое[49], дампы памяти (core dump), которые могут быть созданы автоматически системой либо вручную.

- Алгоритм «волчий загон» — описан Эдвардом Гауссом (1982): «Есть один волк в Аляске. Как его найти? Разделите территорию преградой пополам, определите, на какой стороне волк, повторите процедуру, сужая область поиска». В инструменте Git этот подход реализован в виде команды git bisect, которая находит коммит, в котором появилась ошибка[50].

- Отладка с записью и воспроизведением (англ. Record and Replay Debugging) — создание записи выполнения программы для последующего пошагового анализа. Этот метод позволяет захватить состояние программы и воспроизвести его, что особенно полезно при анализе неустойчивых и трудновоспроизводимых ошибок. Примерами инструментов, реализующих этот подход, являются rr и механизм «Process Record and Replay» в отладчике GDB[51].

- Реверсивная отладка (англ. Reverse Debugging), также известная как отладка с «путешествием во времени» (англ. Time-Travel Debugging, TTD), — технология, позволяющая не только воспроизводить записанное выполнение программы, но и перемещаться по нему в обратном направлении, «отменяя» выполненные инструкции. Это даёт возможность точно определить состояние программы в любой момент, предшествовавший ошибке. Ранняя форма этой функции под названием «Execution History» появилась ещё в 1990 году в Turbo Debugger 2.0[52][53]. Полноценная поддержка реверсивной отладки была добавлена в GDB версии 7.0 в 2009 году[33]. Широкую известность технология получила с выходом WinDbg Preview от Microsoft в 2017 году, где она была реализована под названием Time Travel Debugging[34].

- Дельта-отладка — автоматизированное упрощение тестового случая до минимального проходного примера[54].

- Приём Saff Squeeze — техника прогрессивного «сворачивания» теста для изоляции причины ошибки[55][56].

- Отслеживание причинно-следственных цепочек — методика выявления зависимостей между событиями программы[57] с адаптацией к конкретным ошибкам, например, разыменование нулевых указателей[58].

Методы, использующие искусственный интеллект (ИИ) для автоматизации и оптимизации процесса отладки[59][60].

- Автоматизированное обнаружение и исправление ошибок (англ. Automated Bug Detection and Fixing) — модели ИИ, обученные на больших объёмах кода, анализируют программу на наличие ошибок, уязвимостей и «антипаттернов»[61]. Современные генеративные модели способны не только находить ошибки, но и предлагать варианты их исправления[62][63].

- Предиктивная отладка (англ. Predictive Debugging) — прогнозирование участков кода, где ошибки могут возникнуть с наибольшей вероятностью. ИИ анализирует историю изменений кодовой базы и данные о ранее найденных ошибках, чтобы превентивно указать на рискованные модули[62].

- Интеллектуальный анализ логов — ИИ-инструменты обрабатывают большие объёмы файлов журналов (логов) для выявления аномалий и паттернов, указывающих на ошибки времени выполнения, которые сложно обнаружить статическим анализом[63].

- Самоотлаживающиеся системы (англ. Self-Debugging Systems) — перспективное направление, в котором ИИ-система способна автономно находить и исправлять собственные ошибки без вмешательства человека[64].

Отладка встроенных систем

Главное отличие среды разработки встроенного ПО — большое разнообразие платформ (архитектуры процессоров, производители, операционные системы и их изменения). Как правило, для каждой задачи разрабатывается собственная архитектура для максимальной оптимизации. Это затрудняет не только разработку, но и отладку: для каждой платформы требуется отдельный инструментарий.

Период 2014—2019 годов: Анализ на системном уровне

В этот период рынок инструментов для отладки встраиваемых систем развивался в сторону поддержки всё более сложных многоядерных и гетерогенных систем на кристалле (SoC). Основные усилия были направлены на улучшение визуализации, анализа производительности и отладки на системном уровне.

Компания UltraSoC (ныне часть Siemens EDA) стала одним из пионеров в области встраиваемой аналитики, предложив IP-блоки для мониторинга и отладки SoC изнутри. В 2014 году она запатентовала технологию отладки через USB[65], а в 2018 году анонсировала IDE UltraDevelop 2 на базе Eclipse для анализа производительности многоядерных систем[66]. Ведущие производители, такие как Lauterbach, IAR Systems, Green Hills Software и SEGGER Microcontroller, также обновляли свои флагманские продукты. Lauterbach в 2014 году добавила в TRACE32 функции анализа временных характеристик[67], IAR в 2018 году обновила IAR Embedded Workbench для Renesas RH850 с поддержкой C11/C++14[68], а Green Hills в 2014 году расширила поддержку своей IDE MULTI для новых процессоров[69]. Исследовательские работы были сосредоточены на использовании аппаратной трассировки для диагностики[70] и применении фаззинга прошивок через интерфейс GDB[71].

Период 2020—2023 годов: Поддержка новых архитектур и интеграция

Этот период ознаменовался активной поддержкой новых архитектур, таких как RISC-V и 64-битные Arm, а также интеграцией с популярными редакторами, в частности с Visual Studio Code. В 2020 году Lauterbach более чем вдвое увеличила скорость потоковой передачи данных для трассировщика PowerTrace Serial[72], а в 2021 году представила новое оборудование (PowerTrace III) и добавила поддержку RISC-V и Python для автоматизации[73]. IAR Systems в 2021 году выпустила IAR Embedded Workbench for Arm v9.10 с поддержкой 64-битных ядер[74], а в 2022 году улучшила многоядерную отладку для RISC-V и объявила о поддержке процессоров для космоса (NOEL-V)[75]. SEGGER в 2021 году обеспечила официальную поддержку отладчиков J-Link в VS Code[73], а в 2023 году добавила в SystemView функцию мониторинга кучи для выявления утечек памяти[76]. В академической среде появились такие инструменты, как DIPS (2022) — аппаратный отладчик для систем с прерывистым питанием[77] и μAFL (2022) — фреймворк для неинтрузивного фаззинга прошивок.

Период 2024—2025 годов: Интероперабельность и AI/ML

В эти годы производители сфокусировались на интеграции со сторонними платформами и поддержке рабочих процессов, связанных с машинным обучением (ML). IAR Systems в 2024 году анонсировала новую стратегию, направленную на взаимодействие с открытыми платформами, такими как Zephyr RTOS[78], а в 2025 году представила улучшения для отладки нескольких образов в многоядерных системах[79]. Связка VS Code + PlatformIO получила нативную поддержку рабочих процессов AI/ML[80]. Появились и новые коммерческие инструменты, например, Active-Pro Debugger — высокопроизводительный отладчик на базе ПЛИС и USB 3.0[81][82]. В исследованиях уделяется внимание развитию инструментов с открытым исходным кодом, таких как OpenOCD для архитектуры RISC-V[83].

Кроме поиска ошибок, отладка встроенных систем важна для сбора информации о состоянии работы устройства (энергопотребление, надёжность, соответствие реальному времени и пр.) с целью повышения эффективности и оптимизации.

Защита от отладки — совокупность методов, реализуемых в коде программы, затрудняющих её отладку или анализ[84]. Такие методы активно применяются в системах защиты от копирования, а также вредоносным ПО для затруднения обнаружения и удаления[85]. Существуют следующие методы:

- На основе АПИ: проверка наличия отладчика средствами системы

- На основе исключений: отслеживание влияния на обработку программных исключений

- Блокировка процессов и потоков: анализ изменения структуры процессов/потоков

- Модификация кода: обнаружение изменений программы из-за программных точек останова

- Аппаратные методы: анализ аппаратных точек останова и регистров процессора

- Оценка времени: контроль задержек при выполнении инструкций

- Активное выявление и блокирование отладчика[85]

В качестве одного из старейших примеров антиотладки можно привести поведение ранних версий Microsoft Word, которые при обнаружении отладчика выводили сообщение: «The tree of evil bears bitter fruit. Now trashing program disk.» и вызывали странные шумы дисковода для устрашения пользователя[86][87].

С конца 2000-х годов методы защиты от отладки эволюционировали от простых проверок к созданию многоуровневых и динамических барьеров, направленных на максимальное усложнение анализа кода.

В этот период акцент сместился на использование недокументированных возможностей операционной системы и комбинирование различных техник. Вместо прямого вызова функции IsDebuggerPresent программы начали использовать более глубокие проверки[88]:

- Анализ системных структур: Проверка флагов в структурах процесса, таких как Process Environment Block (PEB), где помимо флага BeingDebugged анализировался NtGlobalFlag[89].

- Системные вызовы: Использование функции NtQueryInformationProcess для получения информации о порте отладки (ProcessDebugPort) или объекте отладки (ProcessDebugObjectHandle)[89].

- Сокрытие потоков: Применение функции NtSetInformationThread с классом ThreadHideFromDebugger позволяло «спрятать» поток от отладочных событий, что приводило к сбою анализатора[90].

- Временны́е атаки: Измерение времени выполнения участков кода с помощью высокоточных счётчиков, таких как инструкция RDTSC, для обнаружения задержек, вносимых отладчиком[91].

- Обнаружение точек останова: Программы сканировали собственный код на наличие инструкции 0xCC (программная точка останова) или проверяли отладочные регистры процессора (DR0-DR7) на наличие аппаратных точек останова[90].

Ключевой тенденцией десятилетия стало наслоение и обфускация этих методов, что делало анализ крайне трудоёмким[90].

В 2020-е годы «гонка вооружений» между разработчиками защит и аналитиками перешла на более глубокий, аппаратный и интеллектуальный уровень.

Техники «анти-хукинга» Значительное развитие получили методы, противодействующие перехвату (хукингу) функций, который используется отладчиками и системами защиты (EDR). Вредоносное ПО, такое как GuLoader, научилось обходить хуки в системных библиотеках (например, NTDLL.dll) или использовать прямые системные вызовы (syscalls), чтобы избежать мониторинга[92][93]. Появились фреймворки, способные программно удалять хуки, установленные средствами анализа, делая программу «невидимой» для них[94].

Война на уровне гипервизоров Борьба переместилась на уровень ниже операционной системы.

- Защита на основе виртуализации (VBS): Технологии, встроенные в современные версии Windows (например, «Целостность памяти»), используют гипервизор для изоляции и защиты ядра, что существенно усложняет его отладку[95].

- Гипервизорные отладчики: В ответ появились отладчики, работающие на уровне гипервизора (Ring -1), такие как HyperDbg. Они используют аппаратные возможности виртуализации (например, Intel VT-x) для создания невидимой для анализируемой программы среды отладки[96]. Это, в свою очередь, стимулировало разработку техник, способных обнаруживать даже такие скрытые отладчики по микроархитектурным аномалиям[97].

Продвинутая обфускация и виртуализация кода

- Виртуализация кода: Сложные протекторы и вредоносные программы (например, Agent Tesla) начали преобразовывать исполняемый код в байт-код для собственной, нестандартной виртуальной машины. Для анализа такого кода требуется предварительно восстановить логику работы этого уникального интерпретатора[98].

- Исполнение в общем буфере: Чтобы сделать неэффективными точки останова, применяется метод, при котором фрагменты кода перед выполнением копируются в один и тот же общий буфер. Поскольку точка останова привязана к адресу, отладчик будет срабатывать при каждом вызове, что делает пошаговый анализ практически невозможным[99].

Применение искусственного интеллекта С начала 2020-х годов ИИ стал применяться для обнаружения аномального поведения системы, характерного для отладки[100]. К 2025 году генеративный ИИ начал активно использоваться для создания динамической обфускации: нейросети генерируют уникальные и «органические» слои запутанного кода для каждой сборки программы, что делает неэффективными универсальные инструменты деобфускации[97].

Примечания

Литература

- Agans, David J. Debugging: The Nine Indispensable Rules for Finding Even the Most Elusive Software and Hardware Problems : [англ.]. — AMACOM, 2002. — ISBN 0-8144-7168-4.

- Blunden, Bill. Software Exorcism: A Handbook for Debugging and Optimizing Legacy Code : [англ.]. — APress, 2003. — ISBN 1-59059-234-4.

- Ford, Ann R. Practical Debugging in C++ : [англ.] / Ann R. Ford, Toby J. Teorey. — Prentice Hall, 2002. — ISBN 0-13-065394-2.

- Grötker, Thorsten. The Developer's Guide to Debugging, Second Edition : [англ.] / Thorsten Grötker, Ulrich Holtmann, Holger Keding … [et al.]. — Createspace, 2012. — ISBN 978-1-4701-8552-7.

- Metzger, Robert C. Debugging by Thinking: A Multidisciplinary Approach : [англ.]. — Digital Press, 2003. — ISBN 1-55558-307-5.

- Myers, Glenford J. The Art of Software Testing : [англ.]. — John Wiley & Sons Inc, 2004. — ISBN 0-471-04328-1.

- Robbins, John. Debugging Applications : [англ.]. — Microsoft Press, 2000. — ISBN 0-7356-0886-5.

- Telles, Matthew A. The Science of Debugging : [англ.] / Matthew A. Telles, Yuan Hsieh. — The Coriolis Group, 2001. — ISBN 1-57610-917-8.

- Vostokov, Dmitry. Memory Dump Analysis Anthology Volume 1 : [англ.]. — OpenTask, 2008. — ISBN 978-0-9558328-0-2.

- Zeller, Andreas. Why Programs Fail, Second Edition: A Guide to Systematic Debugging : [англ.]. — Morgan Kaufmann, 2009. — ISBN 978-0-1237-4515-6.

- Peggy Aldrich Kidwell, В поисках ускользающей ошибки в компьютере, IEEE Annals of the History of Computing, 1998.

Ссылки

- Паттерны анализа дампов памяти — статьи о поиске ошибок по дампам

- Основы отладки — как улучшить навыки отладки

- Плагинная отладка встроенных систем

- Тестирование и отладка встроенных систем: аппаратная генерация цифрового ввода — результаты опроса пользователей (Byte Paradigm, архив)